In diesem Artikel installieren wir Oracle Grid Infrastructure 19c unter Linux. Vor der Oracle Grid-Installation benötigen Sie zunächst ein Betriebssystem. Sie können den folgenden Artikel lesen, um Oracle Linux zu installieren.

Howto Installation von Oracle RAC 19C auf ESXi Teil 1

Zuerst konfigurieren wir die Datenträger.

Da ich ein Test-Setup ausführe, verwende ich 5-Festplatten. Drei dieser Festplatten werden für +CRS verwendet, die anderen beiden für RACDB + FRA.

Ich prüfe meine Datenträger. In der Hypervisor-Umgebung, in der ich arbeite, beginnen meine Festplatten mit SD. Es kann nicht mit SD * in Ihrer Umgebung beginnen. Sie können es je nach Situation beheben.

SDB, SDC, SDD, SDE und SDF sind die Datenträger, die ich als freigegeben hinzugefügt habe. ASM wird hier arbeiten.

|

1 2 3 4 5 6 7 8 |

[root@rac101 ~]# ll /dev/sd* brw-rw—-. 1 root disk 8, 0 Sep 13 13:04 /dev/sda brw-rw—-. 1 root disk 8, 1 Sep 13 13:04 /dev/sda1 brw-rw—-. 1 root disk 8, 2 Sep 13 13:04 /dev/sda2 brw-rw—-. 1 root disk 8, 16 Sep 13 13:04 /dev/sdb brw-rw—-. 1 root disk 8, 32 Sep 13 13:04 /dev/sdc brw-rw—-. 1 root disk 8, 48 Sep 13 13:04 /dev/sdd brw-rw—-. 1 root disk 8, 64 Sep 13 13:04 /dev/sde brw-rw—-. 1 root disk 8, 64 Sep 13 13:04 /dev/sdf |

Ich werde die Festplatten vorbereiten. Dann geht es mit Oracle ASM weiter.

Als nächstes müssen wir die Datenträger formatieren, die ursprünglich zu Knoten 1 hinzugefügt wurden, nur auf Knoten 1

Formatieren Sie die 5 Festplatten, die sdb, sdc, sdd, sde und sdf sein werden.

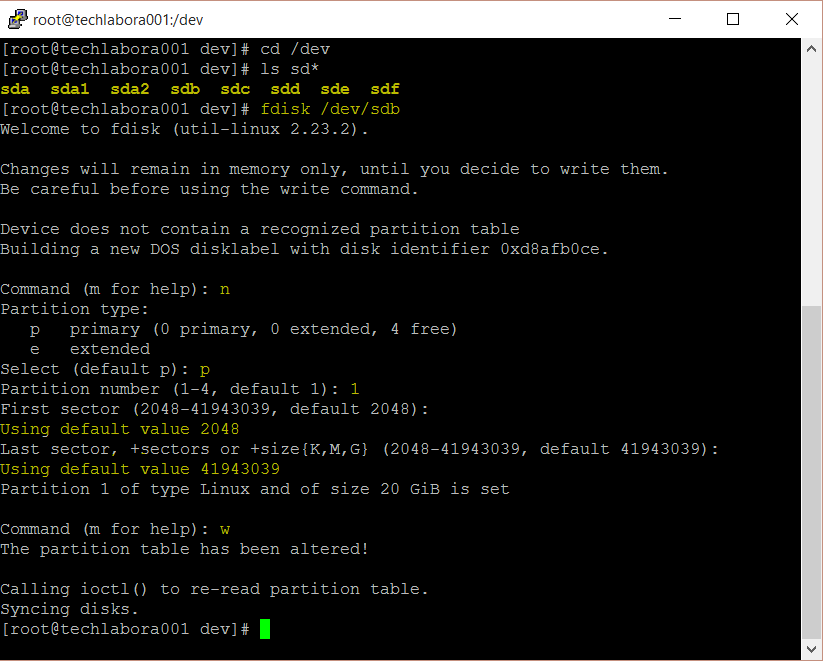

Geben Sie als Beispiel für den ersten Datenträger fdisk /dev/sdb ein.

Typ n für neue

Typ p für primäre

Typ 1 für partitionPress enter

Drücken Sie enter

Drücken Sie enter

Presse unter

Ich mache die folgende Operation auf RAC101. (Es sollten keine Maßnahmen für RAC102 ergriffen werden.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 |

[root@rac101 ~]# fdisk /dev/sdb

Welcome to fdisk (util-linux 2.32.1). Changes will remain in memory only, until you decide to write them. Be careful before using the write command.

Device does not contain a recognized partition table. Created a new DOS disklabel with disk identifier 0xf2177cca.

Command (m for help): n Partition type p primary (0 primary, 0 extended, 4 free) e extended (container for logical partitions) Select (default p): p Partition number (1-4, default 1): 1 First sector (2048-20971519, default 2048): Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519):

Created a new partition 1 of type 'Linux' and of size 10 GiB.

Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks. |

Wir führen diese Operationen für unsere anderen Festplatten (sdc, sdd, sde, sdf)durch. Nachdem unsere Arbeiten abgeschlossen sind, wird es eine Ausgabe wie folgt geben.

|

1 2 3 4 5 6 7 8 9 10 11 12 |

[root@rac101 ~]# ll /dev/sd* brw-rw—-. 1 root disk 8, 0 Sep 13 13:04 /dev/sda brw-rw—-. 1 root disk 8, 1 Sep 13 13:04 /dev/sda1 brw-rw—-. 1 root disk 8, 2 Sep 13 13:04 /dev/sda2 brw-rw—-. 1 root disk 8, 16 Sep 13 13:07 /dev/sdb brw-rw—-. 1 root disk 8, 17 Sep 13 13:07 /dev/sdb1 brw-rw—-. 1 root disk 8, 32 Sep 13 13:07 /dev/sdc brw-rw—-. 1 root disk 8, 33 Sep 13 13:07 /dev/sdc1 brw-rw—-. 1 root disk 8, 48 Sep 13 13:07 /dev/sdd brw-rw—-. 1 root disk 8, 49 Sep 13 13:07 /dev/sdd1 brw-rw—-. 1 root disk 8, 64 Sep 13 13:07 /dev/sde brw-rw—-. 1 root disk 8, 65 Sep 13 13:07 /dev/sde1 |

Wir starten die RAC101- und RAC102-Server neu. Im nächsten Schritt bereiten wir unsere Festplatten für ASM vor.

Wir tun die folgenden Schritte für RAC101 und RAC102.

|

1 2 3 4 |

[root@rac101 ~]# oracleasm update-driver Kernel: 5.4.17-2011.5.3.el8uek.x86_64 x86_64 Driver name: oracleasm-5.4.17-2011.5.3.el8uek.x86_64 Driver for kernel 5.4.17-2011.5.3.el8uek.x86_64 does not exist |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 |

[root@rac101 ~]# oracleasm configure -I Configuring the Oracle ASM library driver.

This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort.

Default user to own the driver interface []: grid Default group to own the driver interface []: asmadmin Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y

The next two configuration options take substrings to match device names. The substring "sd" (without the quotes), for example, matches "sda", "sdb", etc. You may enter more than one substring pattern, separated by spaces. The special string "none" (again, without the quotes) will clear the value.

Device order to scan for ASM disks []: Devices to exclude from scanning []: Directories to scan []: Use device logical block size for ASM (y/n) [n]: y Writing Oracle ASM library driver configuration: done |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 |

[root@rac102 ~]# oracleasm configure -I Configuring the Oracle ASM library driver.

This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort.

Default user to own the driver interface []: grid Default group to own the driver interface []: asmadmin Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y

The next two configuration options take substrings to match device names. The substring "sd" (without the quotes), for example, matches "sda", "sdb", etc. You may enter more than one substring pattern, separated by spaces. The special string "none" (again, without the quotes) will clear the value.

Device order to scan for ASM disks []: Devices to exclude from scanning []: Directories to scan []: Use device logical block size for ASM (y/n) [n]: y Writing Oracle ASM library driver configuration: done |

Unsere Festplatten sind fast vorbereitet. Mit oracleasm init aktivieren wir den Kernel und machen den Stempel auf die Platten drauf.

Wir aktivieren den Kernel auf RAC101- und RAC102-Servern.

|

1 2 3 4 5 |

[root@rac101 ~]# oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Configuring "oracleasm" to use device logical block size Mounting ASMlib driver filesystem: /dev/oracleasm |

|

1 2 3 4 5 |

[root@rac102 ~]# oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Configuring "oracleasm" to use device logical block size Mounting ASMlib driver filesystem: /dev/oracleasm |

Wir werden die Platten zum ASM Volumemanager hinzufügen. Wir tun dies nur auf RAC101.

|

1 2 3 4 5 6 7 8 9 10 11 12 |

[root@rac101 ~]# oracleasm createdisk crs1 /dev/sdb1 Writing disk header: done Instantiating disk: done [root@rac101 ~]# oracleasm createdisk crs2 /dev/sdc11 Writing disk header: done Instantiating disk: done [root@rac101 ~]# oracleasm createdisk crs3 /dev/sdd1 Writing disk header: done Instantiating disk: done [root@rac101 ~]# oracleasm createdisk oradata /dev/sde1 Writing disk header: done Instantiating disk: done [root@rac101 ~]# oracleasm createdisk fra /dev/sdf1 Writing disk header: done Instantiating disk: done |

Wir überprüfen unsere Festplatten.

|

1 2 3 4 5 6 |

[root@rac101 ~]# ll /dev/oracleasm/disks/ total 0 brw-rw—- 1 oracle dba 259, 5 Sep 13 02:38 DATA1 brw-rw—- 1 oracle dba 259, 7 Sep 13 02:38 DATA2 brw-rw—- 1 oracle dba 259, 11 Sep 13 02:39 FRA1 brw-rw—- 1 oracle dba 259, 9 Sep 13 02:38 FRA2 |

Damit der Prozess, den wir durchführen, von Rac102 aus angezeigt wird, führen wir den folgenden Befehl aus.

|

1 2 3 4 5 6 7 8 |

[root@rac102 ~]# oracleasm scandisks Reloading disk partitions: done Cleaning any stale ASM disks… Scanning system for ASM disks… Instantiating disk "CRS1" Instantiating disk "CRS2" Instantiating disk "CRS3" Instantiating disk "ORADB" Instantiating disk "FRA" |

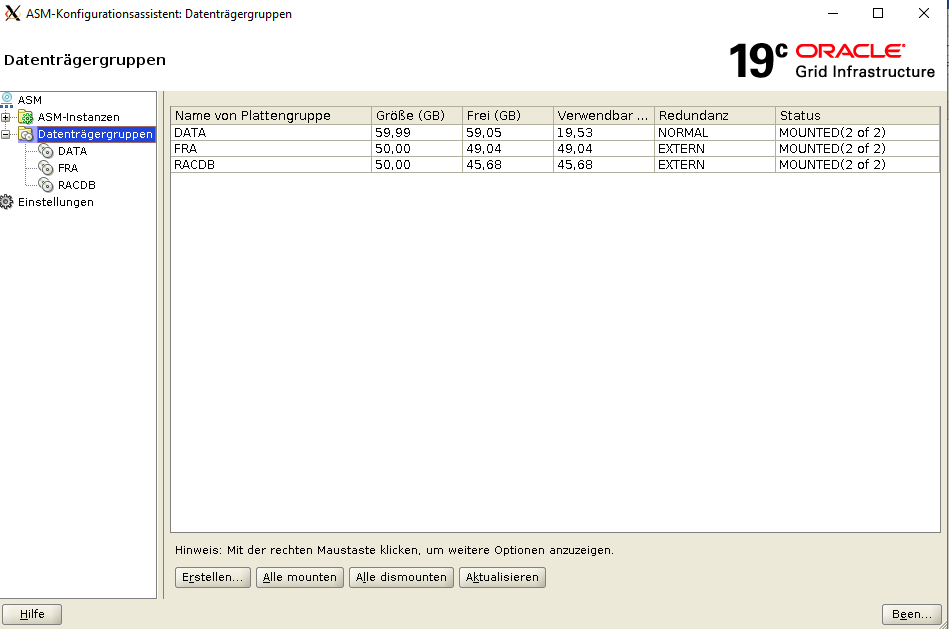

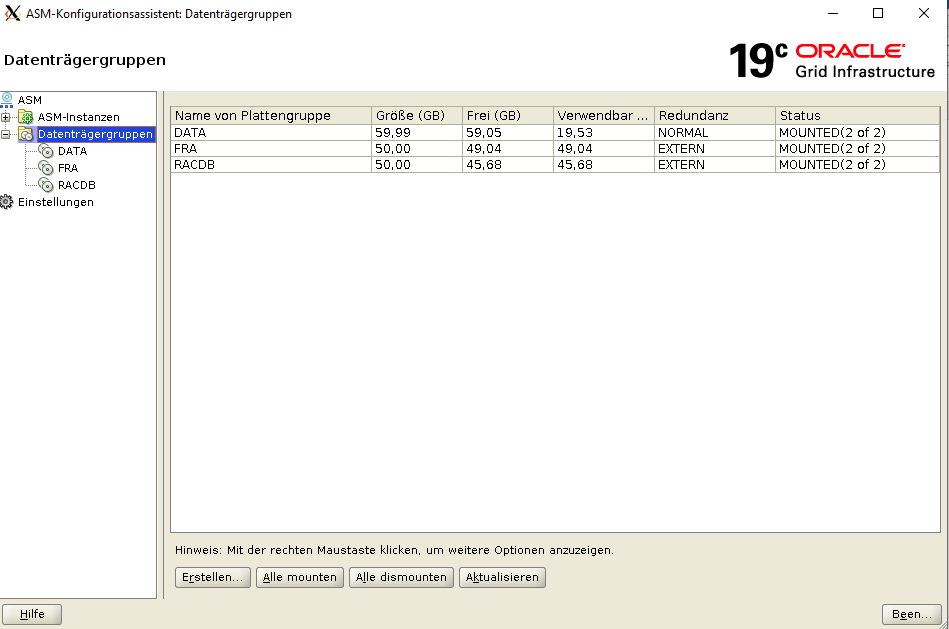

In diesem Abschnitt erstellen wir zwei zusätzliche ASM-Datenträgergruppen mit dem ASM-Konfigurationsassistenten ( asmca). Diese neuen ASM-Datenträgergruppen werden weiter unten in diesem Handbuch beim Erstellen der gruppierten Datenbank verwendet.

Melden Sie sich bei Knoten 1 als User grid an

Typ /u01/app/grid/19.3.0/gridhome_1/bin/asmca und Sie sollten jetzt das folgende Feld erhalten

Klicken Sie auf der Registerkarte Datenträgergruppe auf Erstellen

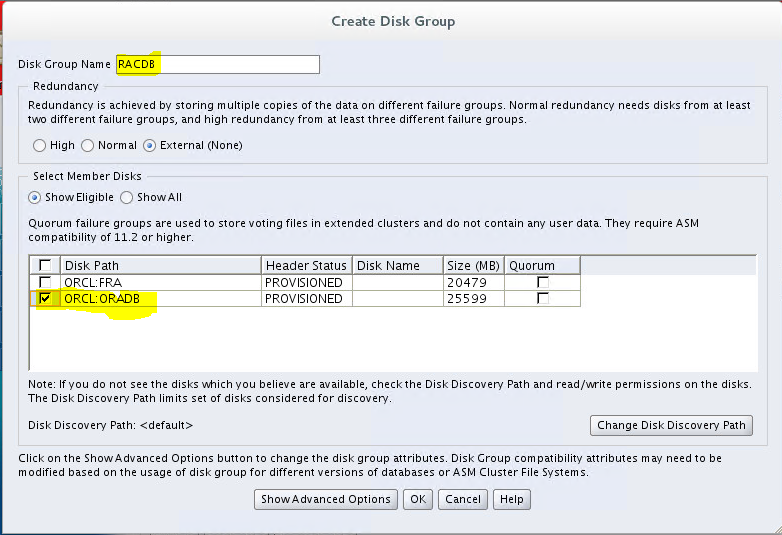

EinName für Ihre Datenträgergruppe eingeben

Auswählen von Datenträgern/Datenträgern

Sie sollten die Bestätigungsmeldung sehen

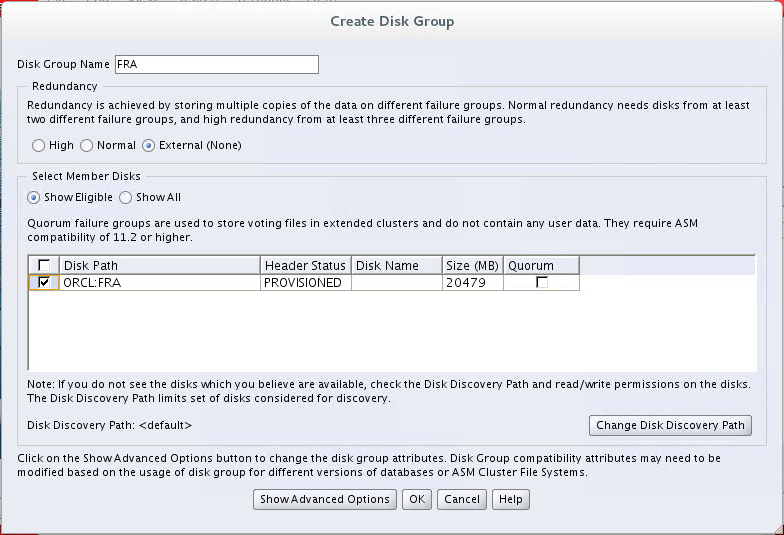

Als Nächstes erstellen Sie die FRA-Datenträgergruppe

Klicken Sie auf der Registerkarte Datenträgergruppe auf Erstellen

Setzen Sie einen Namen für Ihre Disk Group – FRA

Auswählen von Datenträgern/Datenträgern

Stellen Sie sicher, dass Sie eine Bestätigungsnachricht erhalten

Sie sollten jetzt alle Ihre Festplatten sehen

Überprüfen Sie, ob die Clusterdienste vor dem Starten des Installationsprogramms aktiviert sind.

Eingeben /u01/app/12.1.0.2/grid/bin/crsctl Statusressource -t

Unsere Festplatten sind jetzt bereit. Jetzt können wir die Installation starten. Zuallererst werden wir Grid installieren.

|

1 2 3 4 5 6 |

# cp V982068-01.zip /u01/app/grid/19.3.0/gridhome_1 # cd /u01/app/grid/19.3.0/gridhome_1 # chown grid:oinstall V982068-01.zip # su – grid # cd /u01/app/grid/19.3.0/gridhome_1 $ unzip V982068-01.zip |

Clusterüberprüfungsdienstprogramm installieren

Da wir bereits entpackte Software haben, müssen wir ein ganz besonderes Paket installieren, Cluster Verification Utility, das während der Installation der Grid-Infrastruktur verwendet wird.

Auf Knoten 1.

[root@rac101 -]" cp -p /u01/app/grid/19.3.0/gridhome_1/cv/rpm/cvuqdisk-1.0.10-1.rpm /tmp[root@rac10gridhome_1 1 /cvuqdisk-1.0.10-1.rpm rac102:/tmp

Auf beiden Knoten.

[root@rac101 ‚]’rpm -Uvh /tmp/cvuqdisk-1.0.10-1.rpmVerifying…###..###. [100%]Vorbereiten…###. 1:cvuqdisk-1.0.10-1 .

Überprüfen Sie das Ergebnis.

[root@rac101 rpm -q cvuqdiskcvuqdisk-1.0.10-1.x86_64

Clusterüberprüfung

Bevor wir Grid infra installieren, sollten wir überprüfen, ob alles für die Netzinstallation bereit ist. Hier verwenden wir Oracle Cluster Verification Utility (CLUVFY), um zu überprüfen, ob es ein Problem in unserer grid Infrastruktur gibt.

|

[grid@rac101 ~]$ cd $ORACLE_HOME ERROR: Verifying User Equivalence …FAILED (PRVG-2019, PRKC-1191) Verifying Physical Memory … Verifying Users With Same UID: 54322 …PASSED Interface information for node "rac101" Name IP Address Subnet Gateway Def. Gateway HW Address MTU Check: MTU consistency of the subnet "192.168.0.0". Node Name IP Address Subnet MTU Check: MTU consistency of the subnet "2402:7500:52d:1a76:0:0:0:0". Node Name IP Address Subnet MTU Check: MTU consistency of the subnet "192.168.24.0". Node Name IP Address Subnet MTU checking response for name "rac101" from each of the name servers specified Node Name Source Comment Status Node Name Running? Status Node Name Running? Status Pre-check for cluster services setup was unsuccessful on all the nodes. Failures were encountered during execution of CVU verification request "stage -pre crsinst". Verifying User Equivalence …FAILED PRKC-1191 : Remote command execution setup check for node rac102 Verifying Physical Memory …FAILED Verifying RPM Package Manager database …INFORMATION CVU operation performed: stage -pre crsinst |

Wie wir sehen können, gibt es einige Probleme:

- Oracle Inventory-Gruppe

PRVG-10467 : Die standardmäßige Oracle-Inventargruppe konnte nicht ermittelt werden.

Da wir noch nie Oracle-Produkte auf diesem Server installiert haben, ist dieser Fehler normal.

- Benutzeräquivalenz

PRVF-4009 : Benutzeräquivalenz ist nicht für Knoten eingestellt: rac102

oder dies:

PRVG-2019 : Überprüfen Sie die Äquivalenz des Benutzers "Grid" vom Knoten

Wir haben noch keine Benutzeräquivalenz für Grid festgelegt, daher ist dieser Fehler auch normal.

- Physischer Speicher

PRVF-7530 : Ausreichend physischer Speicher ist auf Knoten nicht verfügbar

Das stimmt, wir haben die Anforderung des physischen Speichers nicht erreicht, aber es kann ignoriert werden.

Kein großes Problem hier, also können wir einfach weitermachen.

Weitere Korrekturen

Verschiedene Plattformen können verschiedene Probleme haben, wenn Sie sie getroffen haben, hier sind einige behoben, die hilfreich sein können.

Versionskorrektur

Wenn Sie OUI gestartet haben, wird möglicherweise EIN unerwarteter INS-08101-Fehler beim Ausführen der Aktion im Status "supportedOSCheck" angezeigt, wenn Sie Enterprise Linux 8 oder höher verwendet haben. Sie sollten CV_ASSUME_DISTID Umgebungsvariable auf einen niedrigeren Wert festlegen, um INS-08101 zu lösen,sagen Sie OEL7.8, um OUI glauben zu machen, dass es sich um eine kompatible Betriebssystemversion handelt.

Shared Memory

Bei einigen Servern müssen Sie den freigegebenen Speicher möglicherweise manuell optimieren.

[root@rac101 . vi /etc/fstab… tmpfs /dev/shm tmpfs size=6g 0 0

Oder verwenden Sie MB als Einheit.

tmpfs /dev/shm tmpfs size=6144m 0 0

Um es sofort wirksam zu machen, können Sie dies tun:

[root@rac101 -o mount /dev/shm

Wichtiger Hinweis: Wenn Sie auf OEL 8 installieren. 3, Oracle Database 19C unterstützt diese Version derzeit nicht offiziell. Sie müssen den folgenden Parameter festlegen.

|

1 2 3 4 |

Seine – Raster Export CV_ASSUME_DISTID=OEL8. 1 $ cd /$GRID_HOME/ $ . /grid_Setup. sh |

OpenSSH 8.x Problem: Da Linux 8.3 OpenSSH 8.x verwendet, funktionieren verwandte Befehle wie scp etwas anders als je zuvor. Wenn das Installationsprogramm von Grid infra 19.3 die SSH-Konnektivität überprüft, schlägt dies mit INS-06006 immer fehl. Obwohl Sie die Konnektivität manuell herstellen, kann die SSH-Validierung nicht bestanden werden.

So überprüfen Sie die Version von OpenSSH:

[root@rac101 ~]# ssh -V

OpenSSH_8.0p1, OpenSSL 1.1.1c FIPS 28 May 2019

Problemumgehung

Die Problemumgehung besteht darin, die strikte Überprüfung des Dateinamens durch Hinzufügen einer Option -T zu deaktivieren. Dieses muss auf beiden RAC Knoten vorgenommen werden.

[root@rac101 ~]# cp -p /usr/bin/scp /usr/bin/scp-original

[root@rac101 ~]# echo "/usr/bin/scp-original -T \$*" > /usr/bin/scp

[root@rac101 ~]# cat /usr/bin/scp

/usr/bin/scp-original -T $*

Brechen Sie die Installation ab und versuchen Sie es erneut.

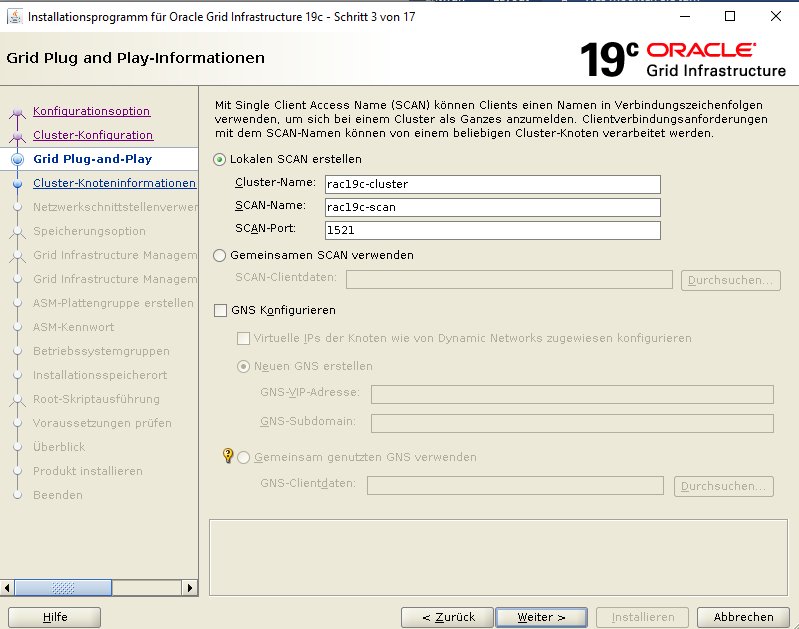

Wir klicken auf "Konfigurieren eines oracle Standalone-Clusters", da wir einen neuen Cluster erstellen werden.

Wir schreiben unsere Clusternamen und Scannamen Informationen.

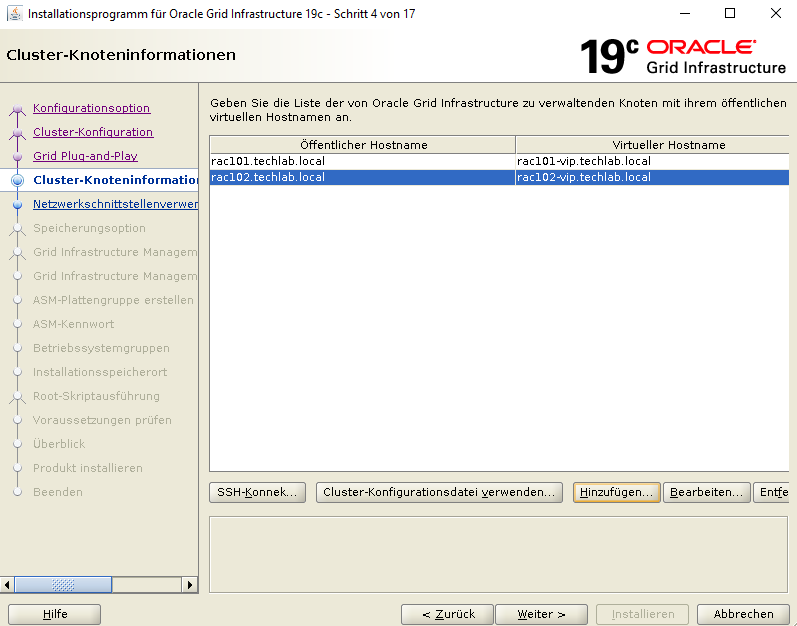

Wir fügen unseren zweiten Server hinzu.

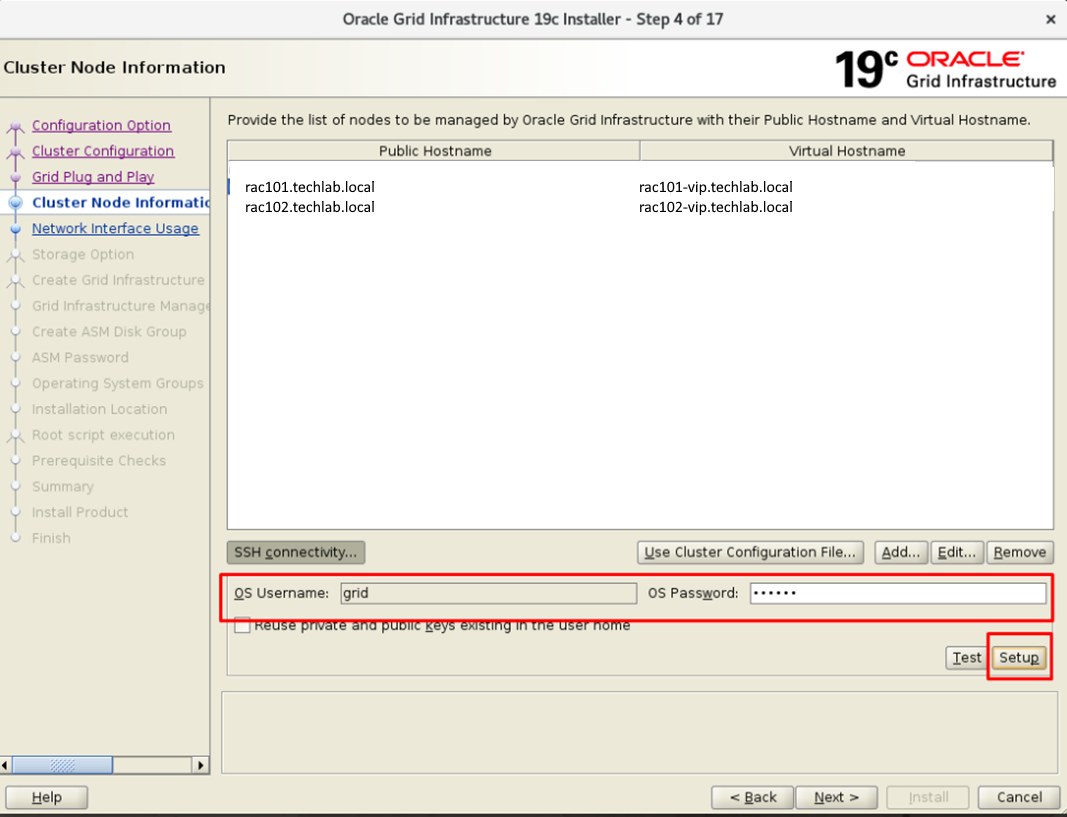

Nach dem Hinzufügen müssen die beiden Server miteinander sprechen. Wir werden SSH dafür verwenden.

In dieser Phase wird das System miteinander mit dem Benutzer "GRID" sprechen. Wir schreiben das Passwort unseres Grid-Benutzers.

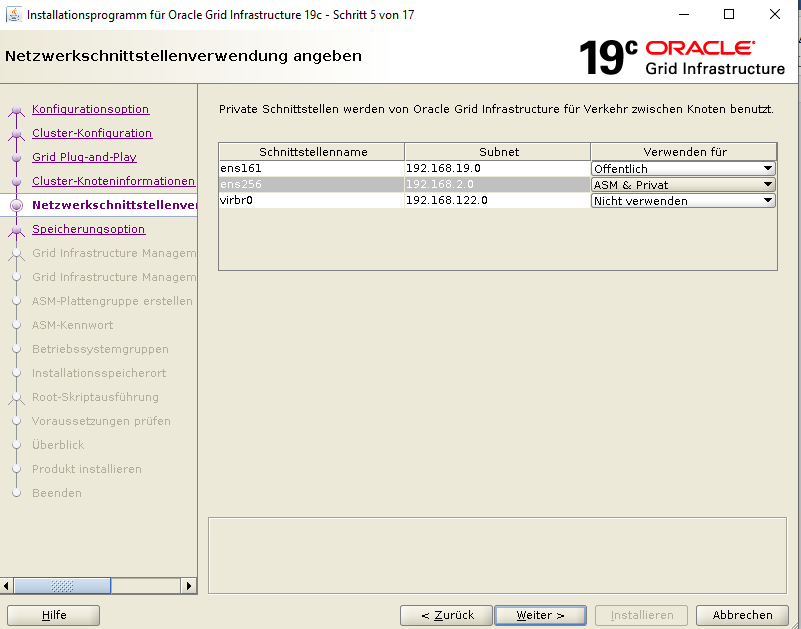

Wir müssen die Netzwerkinformationen schreiben. Wir arrangieren es wie folgt.

Die Installation erfolgt auf den 4 ASM-Festplatten, die wir hinzugefügt haben. Wir klicken auf "Verwenden Sie Oracle Flex ASM für speicher".

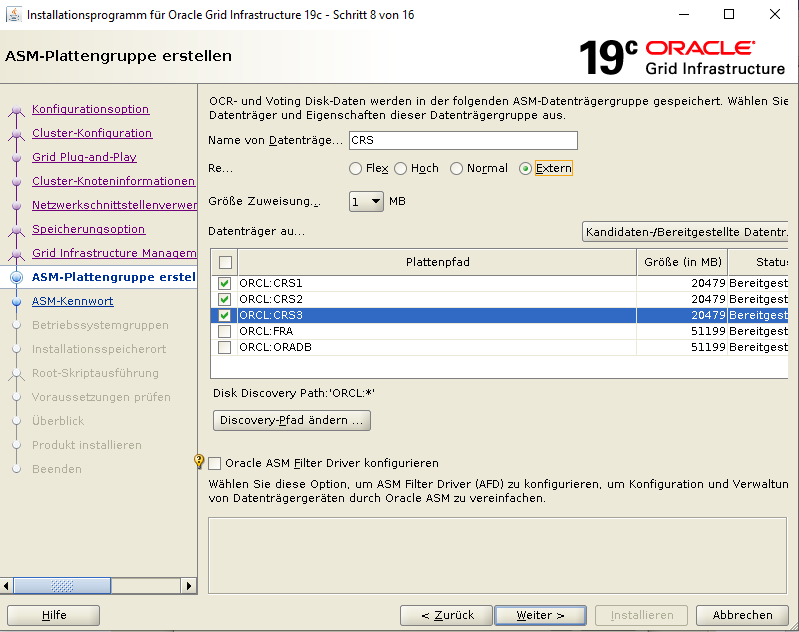

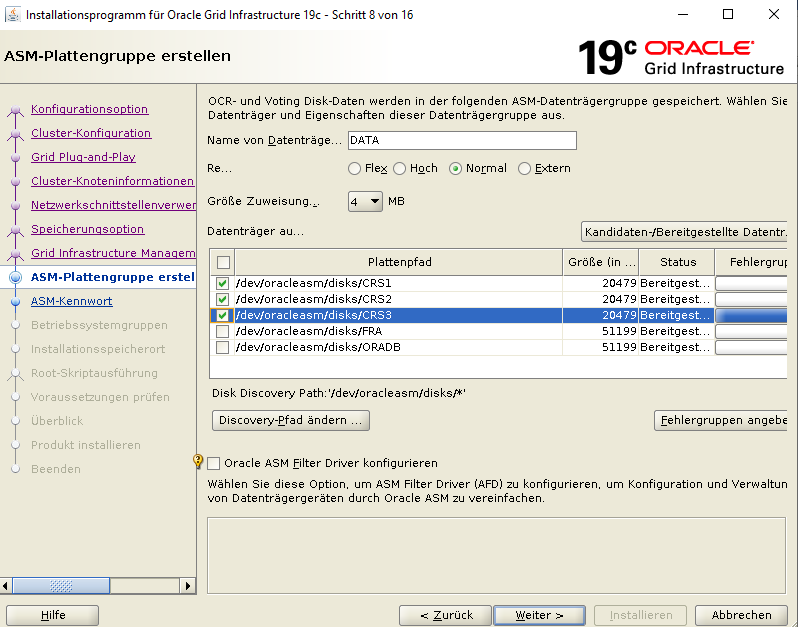

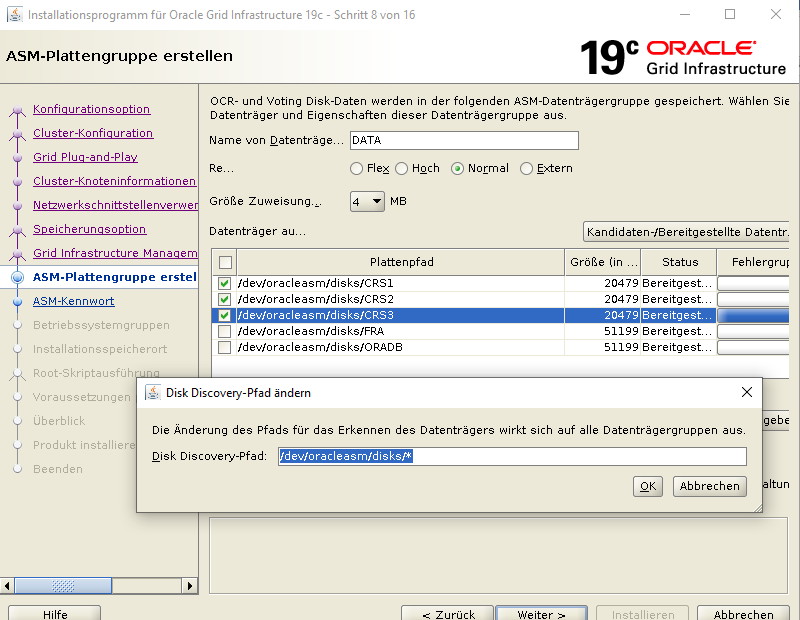

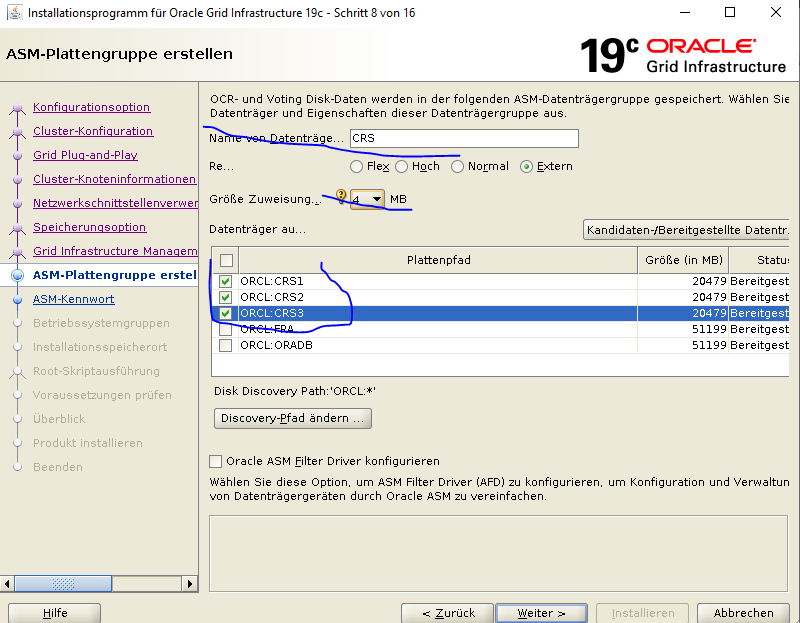

Jetzt werden wir unsere Festplatten hinzufügen. Da ich die Testinstallation gemacht habe, wähle ich "EXTERNAL"  L".

L".

Ich füge meinen CRS1, CRS2, und CRS3 Datenträger hinzu, die ich für die +CRS vorbereitet habe.

Ich habe ein Kennwort für SYS- und ASMSNMP-Benutzer festgelegt, die im Grid verwendet werden sollen.

Oracle führt traditionell im letzten Schritt der Installation ein Skript mit dem Root-Benutzer aus. Wenn wir möchten, dass dieser Prozess automatisch abläuft, können wir dieses Feld ausfüllen. Auf diese Weise wird ein Skript automatisch ausgeführt, wenn ein Skript mit dem Root-Benutzer während der Installation ausgeführt wird.

Der Systemstatus wird überprüft. Einige Warnungen wurden in meiner Installation angezeigt. Beispielsweise reicht RAM nicht aus, da mindestens 12 GB RAM empfohlen werden. Ich klicke auf "IGNORE ALL".

Die GRID-Installation für Oracle Database RAC ist abgeschlossen. Tatsächlich ist das GRID-Setup die längste und anspruchsvollste. Die Grid Installation hat sehr empfindliche Punkte. Wenn NTP beispielsweise falsch ist, liegt ein Problem vor. In userer Distribution gibt es anstatt ntp nur noch den chrony Damon. Dieser muss passend konfiguriert sein. Aufgrund des Clusters muss die Uhr beider Server gleich sein. Aus diesem Grund ist eine saubere GRID-Installation unerlässlich.

Das nächste Kapitel ist die Installation von Oracle Database auf RAC. Dann werden wir unsere Tests machen.